886-0909207262

{{ variable.name }}

請認證我們的賣場

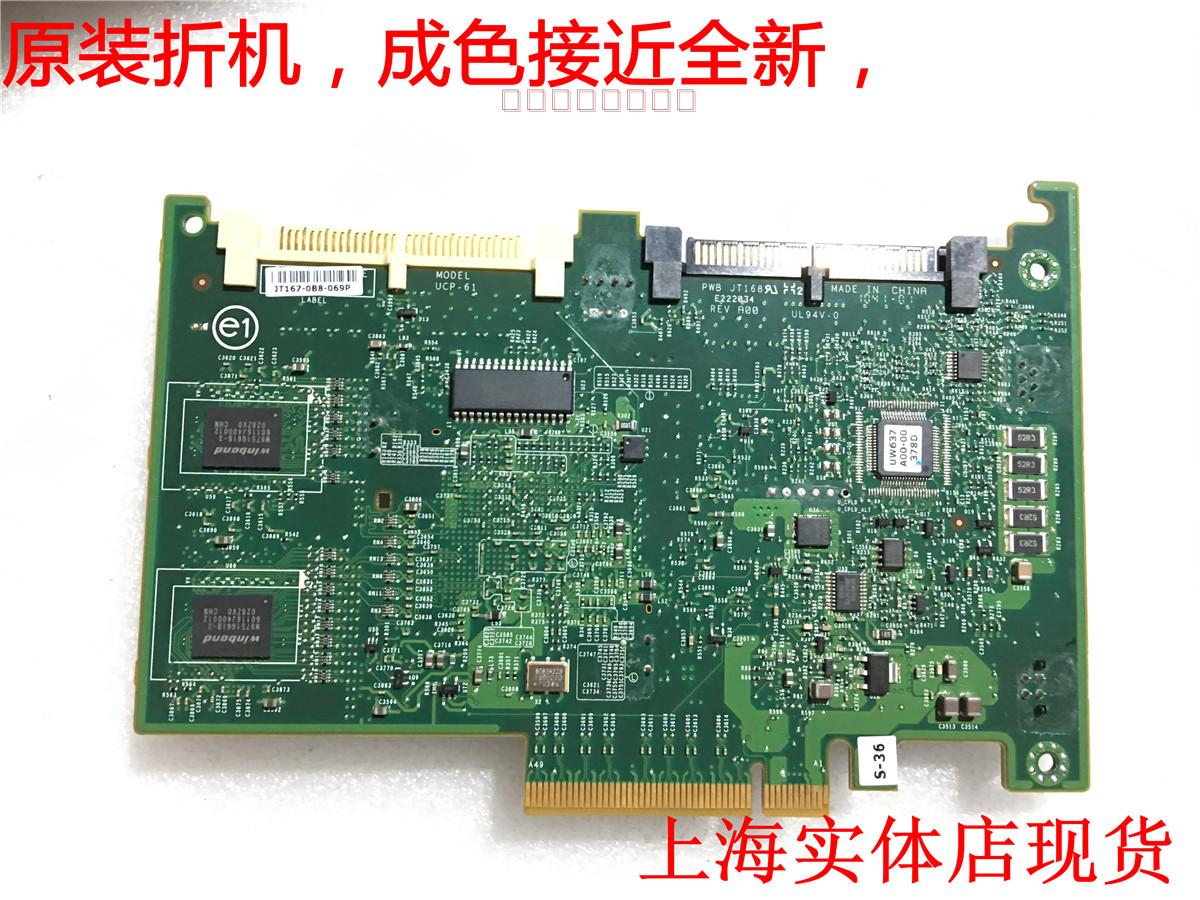

品牌:Dell/戴爾型號:6i SAS陣列卡顏色分類:陣列卡不含電池,卡+電池+電池線,電池,加線電池線支持RAID0,1,5,6,10等陣列級別DELL PERC /6I RAID6卡支持 DELL 11系列服務器 ,R610 R710 R810 R910 R510 T610T710專用RAID6卡備件號:0T954J 不含電池 全新成色, 保三個月 單價45? 含電池70一套DELL Perc 6/i SAS raid卡 PCI-E 6i 陣列卡 帶電池 T954JRADI6技術是在RAID 5基礎上,為了進一步加強數據保護而設計的一種RAID方式,實際上是一種擴展RAID 5等級。與RAID 5的不同之處于除了每個硬盤上都有同級數據XOR校驗區外,還有一個針對每個數據塊的XOR校驗區。當然,當前盤數據塊的校驗數據不可能存在當前盤而是交錯存儲的,具體形式見圖。這樣一來,等于每個數據塊有了兩個校驗保護屏障(一個分層校驗,一個是總體校驗),因此RAID 6的數據冗余性能相當好。但是,由于增加了一個校驗,所以寫入的效率較RAID 5還差,而且控制系統的設計也更為復雜,第二塊的校驗區也減少了有效存儲空間。簡介 英文全稱:Independent Data disks with two independent distributed parity schemes(獨立的數據硬盤與兩個獨立分布式校方案)由于RAID 6相對于RAID 5在校驗方面的微弱優勢和在性能與性價比方面的較大劣勢,RAID 6等級基本沒有實際應用過,只是對更高級的數據的冗余進行的一種技術與思路上的嘗試,下面我們就做一個總結:RAID 5最少需要使用3個硬盤優點:1、相對于RAID 5更高的數據冗余性能;2、堅強的數據保護能力,可以應付多個硬盤同時發生故障;3、完美的任務應急操作應。缺點:1非常復雜的控制器設計;2、計算校驗地址將占用相當多的處理時間;3、由于第二個效驗區,將至少需要N+2個硬盤(N是大于等于1色整數)。RAID-6 是在RAID-5基礎上把校驗信息由一位增加到兩位的raid 級別。RAID-6和RAID-5一樣對邏輯盤進行條帶化然后存儲數據和校驗位,只是對每一位數據又增加了一位校驗位。這樣在使用RAID-6時會有兩塊硬盤用來存儲校驗位,增強了容錯功能,同時必然會減少硬盤的實際使用容量。以前的raid級別一般只允許一塊硬盤壞掉,而RAID-6可以允許壞掉兩塊硬盤,因此,RAID-6 要求至少4塊硬盤。RAID6校驗位具體實現方法與RAID 5相比,RAID 6增加了第二個獨立的奇偶校驗信息塊。兩個獨立的奇偶系統使用不同的算法,數據的可靠性非常高,即使兩塊磁盤同時失效也不會影響數據的使用。但RAID 6需要分配給奇偶校驗信息更大的磁盤空間,相對于RAID 5有更大的“寫損失”,因此“寫性能”非常差。較差的性能和復雜的實施方式使得RAID 6很少得到實際應用。常見的RAID6組建類型 RAID 6(6D + 2P)1 RAID 6(6D + 2P)原理和RAID 5相似,RAID 6(6D + 2P)根據條帶化的數據生成校驗信息,條帶化數據和校驗數據一起分散存儲到RAID組的各個磁盤上。在圖1中,D0,D1,D2,D3,D4和D5是條帶化的數據,P代表校驗數據,Q是第二份校驗數據。RAID 6(6D + 2P)根據條帶化的數據生成校驗信息,條帶化數據和校驗數據一起分散存儲到RAID組的各個磁盤上RAID 6校驗數據生成公式(P和Q):P的生成用了異或P = D0 XOR D1 XOR D2 XOR D3 XOR D4 XOR D5Q的生成用了系數和異或Q = A0*D0 XOR A1*D1 XOR A2*D2 XOR A3*D3 XOR A4*D4 XOR A5*D5D0~D5:條帶化數據A0~A5:系數XOR:異或*:乘在RAID 6中,當有1塊磁盤出故障的時候,利用公式1恢復數據,這個過程是和RAID 5一樣的。而當有2塊磁盤同時出故障的時候,就需要同時用公式1和公式2來恢復數據了。各系數A0~A5是線性無關的系數,在D0,D1,D2,D3,D4,D5,P,Q中有兩個未知數的情況下,也可以聯列求解兩個方程得出兩個未知數的值。這樣在一個RAID組中有兩塊磁盤同時壞的情況下,也可以恢復數據。 上面描述的是校驗數據生成的算法。其實RAID 6的核心就是有兩份檢驗數據,以保證兩塊磁盤同時出故障的時候,也能保障數據的安全。一個RAID-6的陣列中可以最多有16個硬盤。假設一共6塊硬盤,使用4塊創建邏輯盤,raid6,4個硬盤在使用時都被先條帶化,然后分別存儲數據和校驗位。如果一塊硬盤出現物理故障,RAID的會處于降級狀態,但是仍然有容錯功能;如果第二塊硬盤出現故障,邏輯盤中還剩下的兩塊硬盤就不再有容錯功能。如果陣列中有hotspare硬盤,出故障的硬盤上的數據會轉移到hotspare硬盤上,自動進行重建,數據的條帶化存儲方式和原來的兩塊硬盤相同。模型分析[1]內容提要:RAID 6之所以重要,不是因為它能恢復兩個同時發生的磁盤故障,而是能用完好的對等磁盤恢復一個磁盤故障和一個讀取錯誤。隨著磁盤容量的上升,上述這種錯誤的發生幾率也在增加。更為重要的是,低質量SATA磁盤使用比較多,造成這種幾率又要提高10倍乃至百倍。從最基本的角度來說,RAID就是指一組磁盤關聯和相對應的數據布局,在某些組件發生讀取錯誤的情況下仍能確保從系統檢索到數據。RAID 0是基礎條帶化模型,不支持任何冗余,因此可最優化系統性能,但在數據故障情況下不能恢復數據。RAID 5 設計旨在從單次數據故障中恢復數據,通過添加一個冗余校驗盤(“P”盤即奇偶校驗盤),作為對等數據 XOR 計算,從而實現數據恢復功能。從數學角度來說,我們把數據恢復可看作只有一個未知變量(也就是因讀取故障丟失的數據)的線性方程式,并能通過基礎代數方法輕松解出任何線性方程。RAID 6擴展了RAID 5的功能,可在同一數據集上恢復兩個數據錯誤。從數學角度來說,RAID 5使用一個方程式解出一個未知變量,而RAID 6則能通過兩個獨立的線性方程構成方程組,從而恢復兩個未知數據。第一個方程與 RAID 5機制一樣,也是通過添加P盤實現的,而第二個方程則有所不同,將創建一個 盤,因此 RAID 6又稱作“P+Q”盤機制。從理論上說,這種回歸計算可以無限延伸,可創建任意類型的M+N冗余,但實際應用通常僅限于N=2,也就是說數據條帶上同時發生兩個不同的故障,這也就是RAID 6所要解決的主要問題。為什么需要RAID 6?RAID 5可獨立解決磁盤不能檢索數據的兩種情況:一個磁盤損壞,也就是說不能對任何讀寫命令做出響應,需要更換。RAID 5能從保存的對等數據中恢復所有數據,重建缺陷磁盤。磁盤組本身沒問題,但其中一個磁盤上出現了壞塊(即不能讀取的塊),造成某些數據不能恢復。請注意,從數學角度說,每個磁盤的平均無故障時間 (MTBF) 大約為 50 萬至 150 萬小時(也就是每 50~150 年發生一次硬盤損壞)。實際往往不能達到這種理想的情況,在大多數散熱和機械條件下,都會造成硬盤正常工作的時間大幅減少。考慮到每個磁盤的壽命不同,陣列中的任何磁盤都可能出現問題,從統計學角度說,陣列中 N 個磁盤發生故障的機率比單個磁盤發生故障的機率要大 N 倍。結合上述因素,如果陣列中的磁盤數量合理,且這些磁盤的平均無故障時間 (MTBF) 較短,那么在磁盤陣列的預期使用壽命過程中,就很有可能發生磁盤故障(比方說每幾個月或每隔幾年就會發生一次故障)。兩塊磁盤同時損壞的幾率有多大呢(“同時”就是指一塊磁盤尚未完全修復時另一塊磁盤也壞掉了)?如果說 RAID 5 陣列的MTBF相當于MTBF^2,那么這種幾率為每隔1015個小時發生一次(也就是1萬多年才出現一次),因此不管工作條件如何,發生這種情況的概率是極低的。從數學理論角度來說,是有這種概率,但在現實情況中我們并不用考慮這一問題。不過有時卻是會發生兩塊磁盤同時損壞的情況,我們不能完全忽略這種可能性,實際兩塊磁盤同時損壞的原因與MTBF基本沒有任何關系。讀取錯誤(不能恢復的ECC讀取錯誤)從統計角度來說也比較少見,一般來說是指讀取多少位后會出現一次讀取錯誤。就 SCSI/ FC/ SAS 磁盤(SAS 是本文的重點,但同樣的量化說明適用于所有這三種技術)來說,發生讀取錯誤的幾率為每讀取10^15位(也就是約100TB)到10^16位(約 1000TB 或 1PB),會出現一次錯誤。我們把這一幾率稱作誤碼率 (BER)。不過,SATA磁盤的錯誤率要大一些,其BER比其它類型的磁盤要高出一兩個數量級(即其BER為每讀取10^14到10^15位出現一次錯誤,或者說每讀取10/100TB 出現一次錯誤,具體取決于磁盤設計)。如果 SATA 磁盤容量為1TB,完整讀取磁盤十次,就會發現新的故障塊(假定這里的 BER 為每讀取10^14位出錯一次)。存儲相同數據的相應兩個塊同時出現問題幾乎是不可能的,幾率為每讀取 10^30 位發生一次。然而,如果一個問題由于MTBF引起,另一個問題由于讀取錯誤引起,這樣兩個錯誤同時發生的幾率有多大?假設我們有 10 個 SAS 磁盤組成的陣列,每個磁盤容量為 300GB,BER為每讀取10^-15 位出錯一次,那么我們在重建磁盤時發生讀取錯誤的可能性有多大?計算方法如下: 10^15(位)X 1/8 (字節/位)X 1/10 (磁盤)X 1/300GB,從而得到每 50 次重建就會出現一次。這種幾率還是比較大的,但并不足以讓人震驚,要是磁盤陣列在使用壽命中要發生50次故障的話,那才真成了問題!不過,上述幾率在統計學上還是有意義的,我們可以換一種方式來理解,也就是說,如果我們出售50款與上述配置一樣的陣列,那么至少其中一個會出現上述嚴重問題。這種幾率也不算高,但要是客戶安裝上百個陣列的話,問題就比較嚴重了。不過,有的SAS磁盤的BER比我們這里假定的情況要好上10倍,因此問題可以大大化解。如果使用SATA會有什么情況呢?磁盤容量越大,問題就越嚴重!磁盤的BER會較差,造成問題的嚴重性。假定同樣有上述10個磁盤組成陣列,但每個磁盤容量為500GB,BER為讀取10^-14位出錯一次,那么計算如下:10^14 X 1/8 X 1/10 X 1/500GB,得出每 2.5 次重建就會出一次嚴重問題,這就要引起我們的高度重視了。我們這里所談的是5TB容量的陣列,盡管這種陣列還不太常見,但完全是當前技術可以達到的水平。這就是說,這種容量大小的陣列每 2.5 個中,就有一個陣列會出現每次重建就發生塊損壞的問題,用戶會看到“Read Error at LBA = 0xF43E1AC9”這類報錯信息,著實讓人頭痛。用戶怎么會明白0xF43E1AC9 到底指什么?是說空間為空?還是說內核數據下次重啟會發生藍屏錯誤?是僅涉及沒人會用得到的數據庫?還是包含著銀行帳戶信息?實際上看到這種錯誤信息我們根本無所做出判斷,唯一的辦法就是從備份中恢復數據,這會花大量時間,而且還要考慮到從 5TB 容量的磁帶中恢復數據會面臨多大的讀取錯誤幾率。這種讀取錯誤的幾率要大大高于磁盤,因此用戶會遇到無窮盡的問題。說到底,我們要在價格與風險之間進行權衡,SAS和高端驅動器的平均無故障時間 (MTBF) 更長/BER性能更高,因而出問題的可能性也就少得多(盡管不是不可能出問題),而低端SATA 有助于大幅節約購買設備的資本投入,卻會面臨較高的雙重故障幾率。在此情況下,RAID6 市場便應運而生。